Misschien heb je al vaker iets gelezen over A/B tests, of voer je ze zelfs al uit met bijvoorbeeld de onderwerpen van je e-mails of met je sociale media posts.

Maar ondanks dat er in de marketingwereld eindeloos gepraat wordt over A/B testing, wordt het vaak alsnog onjuist uitgevoerd. Hierdoor nemen mensen belangrijke beslissingen voor hun bedrijf op basis van inaccurate resultaten van een verkeerd uitgevoerde test.

In dit artikel vertellen we je alles wat je moet weten om aan de slag te gaan met verschillende soorten A/B testing specifiek voor webshops.

Inhoudsopgave

- Wat is A/B testing?

- Hoe werkt een A/B test?

- Wat is een A/B/n test?

- Wat is de beste loopduur voor een A/B test?

- Wat is het nut van A/B testing?

- Voor welke zaken kun je een A/B test gebruiken?

- A/B test ideeën rangschikken

- Een spoedcursus statistiek voor A/B tests

- Een A/B test opzetten

- Zo analyseer je de resultaten van je A/B test

- Zo bewaar je de resultaten van je A/B tests

- Zo pakken professionals hun A/B tests aan

- A/B tests optimaliseren voor jouw bedrijf

Wat is A/B testing?

Met een A/B test, ook wel een split test genoemd, vergelijk je twee versies (versie A en versie B) van dezelfde website, e-mail of andere digitale communicatie, om te bepalen welke van de twee het beste werkt.

Via een A/B test kun je het antwoord vinden op belangrijke vragen in je bedrijf, de omzet van je bestaande bezoekers verhogen en de basis leggen voor een op data gestoelde marketingstrategie.

Meer lezen: Zo doe je een SWOT-analyse voor je bedrijf

Zo werkt een A/B test

Bij A/B testing in een marketingcontext laat je 50% van je bezoekers versie A van je digitale item zien (ook wel de controle-versie genoemd), en 50% van de bezoekers versie B (ook wel de variant genoemd).

De versie die tot de meeste conversies leidt komt als winnaar uit de bus. Als bijvoorbeeld de variant (oftewel versie B) de hoogste conversieratio heeft, wordt dat de winnaar en krijgen voortaan 100% van je bezoekers deze versie te zien.

Vervolgens wordt deze variant de nieuw controle-versie, en ga je aan de slag om een nieuwe variant te ontwerpen.

Let op: De conversieratio resultaten van je A/B test staan niet gelijk aan gegarandeerd succes, want als je alleen op conversieratio zou afgaan, zou al je producten gratis weggeven het allerbeste scoren en dat is een enorm slecht idee.

Daarom heeft een conversie(ratio) pas echt waarde als hij vergezeld gaat van het geluid van een rinkelende kassa.

Wat is een A/B/n test?

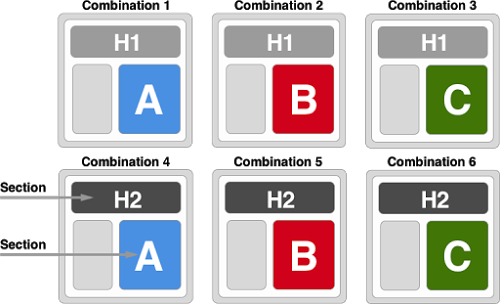

Bij een A/B/n test vergelijk je meer dan één variant met de controle-versie. Dus in plaats van 50% van je bezoekers de controle-versie en 50% van je bezoekers de variant te laten zien, laat je bijvoorbeeld 25% van de bezoekers de controle-versie zien, 25% de eerste variant, 25% de tweede variant en 25% de derde variant.

Let op: Dit is iets anders dan een multivariant test. Bij een multivariant test vergelijk je niet alleen verschillende varianten, maar je test ook meerdere onderdelen, zoals een A/B test voor UX en een split test voor SEO. Het doel hiervan is om uit te vogelen welke combinatie het best presteert.

Om multivariant testen uit te kunnen voeren heb je heel veel bezoekers nodig, dus daar hoef je je nu nog niet mee bezig te houden.

Wat is de beste loopduur voor A/B testing?

Laat je test in ieder geval één en liever nog twee bedrijfscycli lopen, ook als je voor je gevoel al veel eerder een significant resultaat ziet. Daarnaast is het belangrijk om te zorgen dat je de steekproefgrootte die je van tevoren hebt bepaald ook echt bereikt, en dat je de resultaten per week (van zeven dagen, niet vijf) bekijkt.

Waarom twee bedrijfscycli?

- Zo weet je zeker dat je ook de klanten die “er nog even over na willen denken” erbij pakt.

- Zo weet je zeker dat je alle soorten bezoekersbronnen (Facebook, e-mail nieuwsbrief, Google zoeken) meeneemt.

- Zo kun je ook uitzonderingen meerekenen, zoals bijvoorbeeld je vaste vrijdagse nieuwsbrief.

Als je ooit eerder een A/B of landing page test-tool hebt gebruikt, ben je vermoedelijk bekend met het kleine groene “statistisch significant” icoontje.

Helaas interpreteren veel mensen dit als het teken dat de test klaar is en de winnaar vaststaat. Maar hieronder leggen we je uit waarom het feit dat je statistische significantie bereikt hebt nog niet betekent dat je de test meteen kunt stopzetten.

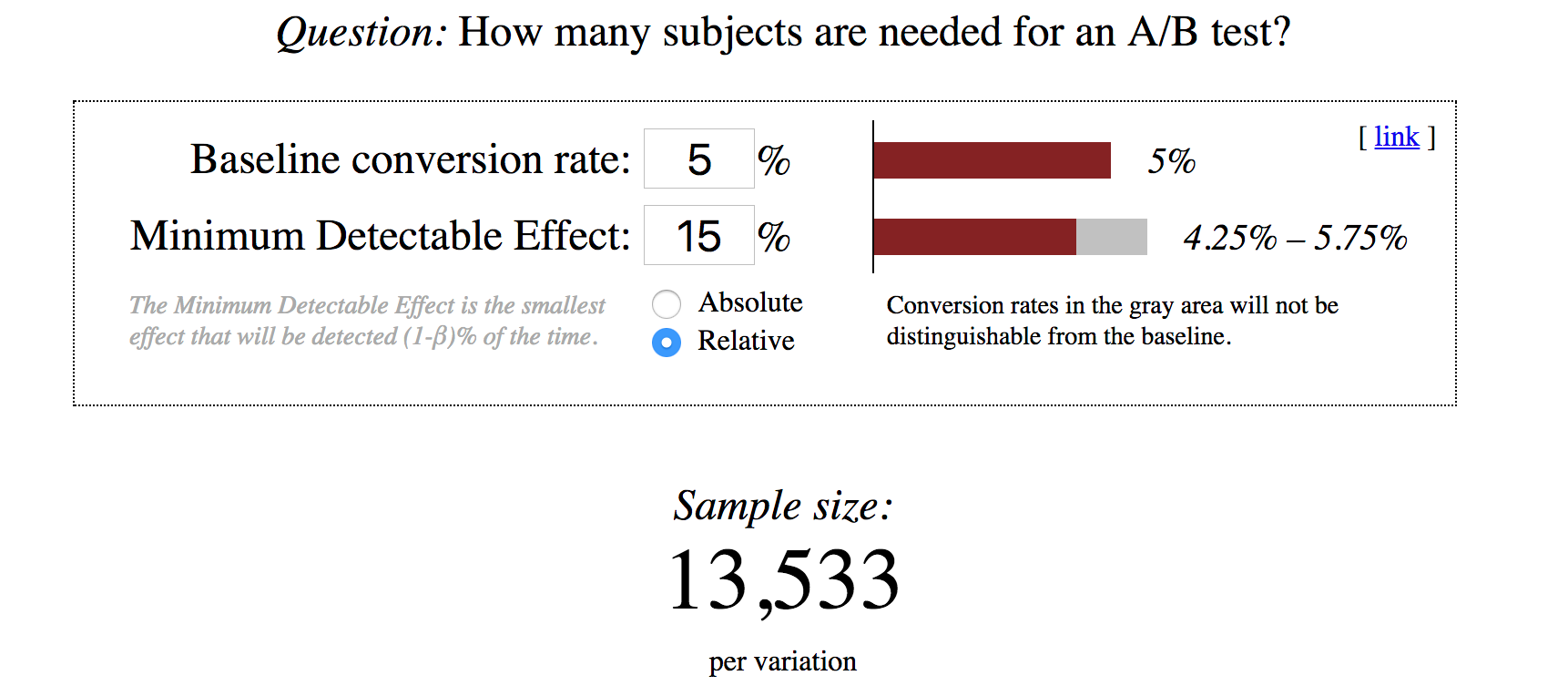

En de vooraf bepaalde omvang van je steekproef? Die is makkelijker te berekenen dan je denkt met een sample size calculator zoals deze van Evan Miller (Engelstalig).

Uit bovenstaande berekening blijkt dat als je conversieratio momenteel 5% is en je een effect van 15% wilt zien, je per variant (inclusief de controle-versie) een steekproef van 13.533 bezoekers nodig hebt. Dat betekent dat je voor een standaard A/B test dus iets meer dan 25.000 bezoekers nodig hebt.

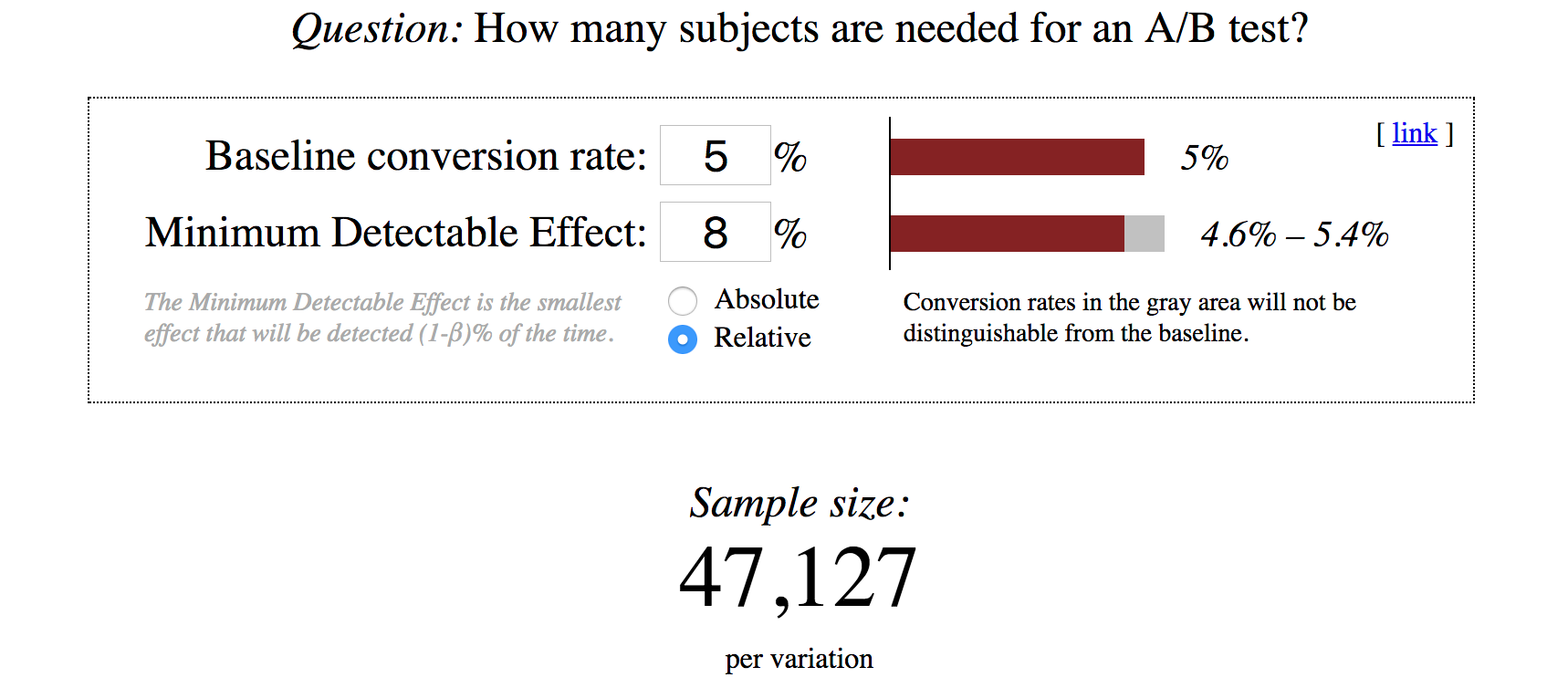

Wat gebeurt er als je een kleiner effect wilt zien?

Het enige wat we veranderd hebben is het minimum detectable effect (minimale waarneembare effect – MDE). We hebben het verlaagd van 15% naar 8%. In dat geval heb je 47.127 bezoekers per variant nodig, dus bijna 100.000 bezoekers voor een standaard A/B test.

Of je nu je UX (user experience) aan A/B testing wilt onderwerpen of je SEO-ideeën met een split test wil valideren, het is altijd belangrijk om de omvang van je sample te berekenen voordat je met de test begint. En ook al heb je al significante resultaten bereikt, je kunt de test niet stopzetten totdat je het exacte aantal bezoekers hebt bereikt. Als je hem eerder stopzet, zijn de resultaten van de test ongeldig.

Dat is ook de reden dat je de test niet moet beëindigen zodra je een bepaald doel bereikt hebt, bijvoorbeeld 100 conversies.

Daarnaast is het belangrijk om de test in eenheden van een hele week te runnen. Je bezoekersaantallen kunnen afhankelijk van tijdstip en dag van de week sterk wisselen, dus zorg dat je alle 7 dagen meeneemt.

Wat is het nut van A/B testing?

Stel dat je € 100 uitgeeft aan Facebook-advertenties, wat tot 10 bezoeken aan je site leidt. Je gemiddelde bestelwaarde is € 25. Van de 10 bezoekers kopen acht niets, en de andere twee besteden elk € 25. Dan heb je netto € 50 verlies geleden (€ 100 uitgegeven, 2x € 25 teruggekregen).

In een tweede scenario geef je ook weer €100 uit aan Facebook ads en je houdt er ook weer 10 bezoekers aan over. Je gemiddelde bestelwaarde is nog steeds €25. Maar deze keer kopen slechts vijf bezoekers niets, terwijl de andere vijf bezoekers elk €25 besteden. Nu heb je €25 winst gemaakt (€ 100 uitgegeven, 5x € 25 teruggekregen).

Dit is een heel simpel voorbeeld van de twee varianten in een A/B test. Maar het geeft aan dat door de conversieratio te verhogen, dezelfde hoeveelheid bezoekers veel waardevoller wordt.

De tekst en afbeeldingen van de varianten in je A/B tests kunnen je ook nieuwe inzichten geven, of je test nu wel of niet goed uitpakt. De dingen die je te weten komt door een test zijn vaak heel goed toepasbaar op allerlei andere zaken rondom marketing. Een nieuw inzicht over bijvoorbeeld copywriting, dat je hebt opgedaan in een A/B test van twee soorten productbeschrijvingen, kun je vaak ook vertalen naar waardeproposities, productvideo’s en andere plaatsen waar je je producten moet omschrijven.

Daarnaast is het altijd waardevol om je op constante verbetering van de effectiviteit van je webshop te richten.

Is A/B testing iets voor mijn webshop?

Niet elke webshop is geschikt voor A/B tests (of heeft ze nodig). Als je een webshop hebt met weinig bezoekers, of eigenaar van een web-app of mobiele app bent, zijn A/B tests vermoedelijk niet de meest effectieve tools voor optimalisatie. In deze gevallen leveren gebruikerstesten of simpelweg met je klanten praten vermoedelijk veel betere informatie op.

We staren ons vaak blind op A/B tests, maar voor het optimaliseren van je conversieratio is alleen een A/B test uitvoeren niet genoeg.

Eerder bespraken we dat je 47.127 bezoekers per variant nodig hebt om een effect van 8% te zien bij een gewoonlijke conversieratio van 5%. Stel dat je een productpagina wilt testen. Gaat het je lukken om daar binnen 2-4 weken bijna 100.000 bezoekers op te krijgen?

Waarom die 2-4 weken? Zoals eerder gezegd is het belangrijk om een test ten minste twee volle bedrijfscycli te runnen, en dat komt meestal neer op 2-4 weken. Misschien denk je: “Dan run ik de test toch langer, tot ik het juiste aantal bezoekers heb bereikt?” Helaas, dat is ook geen goed idee, want hoe langer een test duurt, hoe gevoeliger hij wordt voor “vervuiling van buitenaf”. Bezoekers kunnen bijvoorbeeld hun cookies verwijderen en op die manier als een nieuwe bezoeker geregistreerd worden door de test. Of één persoon bezoekt je site zowel via zijn laptop als via zijn telefoon, en ziet daardoor alle twee de varianten.

In essentie komt het erop neer dat je test te lang laten lopen net zo nadelig is als te kort.

Daarom is testen alleen de moeite waard voor webshops die binnen 2-4 weken het vereiste bezoekersaantal kunnen bereiken. Als dat met jouw webshop (nog) niet lukt, zijn er tot die tijd andere methodes beschikbaar om je conversieratio te optimaliseren.

Julia Starostenko, data scientist bij Shopify, is het daarmee eens:

Waarvoor kun je A/B testing gebruiken?

Ik kan je niet precies vertellen waar je wel en niet een A/B test voor moet doen. Ja, ik weet ‘t, het zou zoveel eenvoudiger zijn als ik je een handige lijst kon geven van 99 dingen die je meteen kunt gaan testen. En er zijn meer dan genoeg marketeers die wel dat soort lijsten schrijven, puur voor de clicks.

Maar in werkelijkheid zijn de enige tests die de moeite waard zijn om te runnen de tests die over jouw eigen data gaan. Ik heb geen toegang tot jouw data, jouw klanten, etc., en de mensen die lange lijsten met A/B test ideeën schrijven hebben dat ook niet. Niemand kan je vertellen wat je moet testen.

Alleen tests met jouw eigen data zijn de moeite waard om uit te voeren.

Wat ik wel kan doen is je helpen om door middel van kwalitatieve en kwantitatieve analyse antwoord te vinden op deze vraag. Hieronder een aantal voorbeelden van populaire A/B test-types:

- Technische analyse. Laadt je webshop snel en goed voor iedereen en bij elk bezoek? Op elk apparaat? Zelf heb je misschien al een nieuwe iPhone 11, maar één van je bezoekers heeft misschien nog een Motorola Razr uit 2005. Als je website niet goed (en snel) laadt, weet je zeker dat je conversies misloopt.

- Mini-enquêtes op je website. Deze pop-ups verschijnen tijdens het browsen. Bezoekers die al een tijdje op je site zijn krijgen bijvoorbeeld de vraag of er iets is wat ze ervan weerhoudt om een aankoop te doen, en zo ja wat dan? Deze kwalitatieve data kun je gebruiken om je webteksten en conversieratio te verhogen.

- Interviews met klanten. Niets geeft zulke bruikbare informatie als je klanten opbellen en met ze praten. Waarom kozen ze voor jouw webshop en niet die van de concurrent? Welke onvervulde behoefte (“Ik had nog geen badpak voor mijn vakantie.”) wilden ze vervullen toen ze op je site kwamen? Er zijn oneindig veel vragen die je kunt stellen om erachter te komen wie je klanten zijn en waarom ze naar jouw webshop komen.

- Langere enquêtes voor klanten. Dit zijn grotere enquêtes die je voorlegt aan mensen die al eens iets bij je gekocht hebben (dus meer dan alleen bezoekers). Bij het ontwerpen van deze enquêtes is het belangrijk om je op het volgende te focussen: Wie zijn je klanten precies, wat zijn hun behoeftes, waarom twijfel(d)en ze over hun aankoop, en welke woorden zouden zij gebruiken om jouw bedrijf te omschrijven?

- Analyse van je analyse. Werken de analytische tools die je gebruikt om data te verzamelen en te rapporteren wel? Dit klinkt misschien vreemd, maar je zou verbaasd staan als je hoorde hoeveel analytische tools verkeerd afgesteld staan. Het analyseren van je analyses draait om het gedrag van je bezoekers. Je kunt bijvoorbeeld focussen op de funnel. Waar zit lekkage in je conversiefunnel? Waar haken bezoekers af? Dat is een goed beginpunt voor een test.

- User testing. In dit scenario observeer je betaalde deelnemers tijdens een gecontroleerd experiment waarbij ze taken uitvoeren in jouw webshop. Je vraagt ze bijvoorbeeld om een videogame te vinden die tussen de € 40 en € 60 kost en hem aan hun winkelmandje toe te voegen. Terwijl ze de taak uitvoeren vertellen ze precies wat ze denken en doen.

- Session replays. Session replays werken hetzelfde als user testing, maar dit keer zijn het geen proefkonijnen maar echte klanten die met hun eigen geld iets willen kopen. Jij kijkt toe terwijl ze in jouw webshop rondkijken. Zijn er dingen die ze niet of lastig kunnen vinden? Tegen welke frustraties lopen ze aan? Zijn er zaken die hen in de war brengen?

Er zijn nog meer testtypen, maar het beste is om te beginnen met de tests uit de bovenstaande lijst die het beste bij je passen. Welke elementen uit je webshop kun je testen in die categorieën? Als het goed is heb je binnen de kortste keren een giga-lijst van ideeën die je kunt testen. En ik weet zeker dat die lijst veel relevanter is voor jouw webshop dan een “99 dingen om nu een A/B test mee te doen” artikel van het internet.

Welke A/B test doe je als eerste?

Een gigantische lijst met ideeën voor A/B tests is een fantastisch begin, maar hij vertelt je niet welke tests het belangrijkste zijn om als eerste te doen.

Gelukkig zijn er een aantal frameworks die je kunnen helpen met deze keuze:

- ICE. Oftewel impact, confidence and ease (impact, zekerheid, gemak). Je geeft elke test op je lijst een cijfer van 1-10 voor elk van deze factoren. Als je bijvoorbeeld makkelijk zelf een test kunt uitvoeren zonder hulp van een developer of ontwerper geef je ease een 8. Let wel, met het ICE framework ga ja uit van je eigen subjectieve beoordeling, dus als je deze oefening als team doet kan het zijn dat iedereen verschillende beoordelingen geeft. Zorg in dat geval dat je van tevoren afspreekt waar jullie je beoordeling op baseren, zodat iedereen zo objectief mogelijk blijft.

- PIE. Oftewel potential, importance, ease (potentieel, belang, gemak). Net als bij ICE krijgt elke factor een cijfer van 1-10. Als een test bijvoorbeeld door 90% van je bezoekers gezien gaat worden, krijgt importance een 8. PIE is net zo subjectief als ICE, dus ook hier is het een goed idee om van tevoren te bedenken waar je je beoordeling op gaat baseren.

- PXL. PXL is een rangschikkingsframework van CXL. Het wijkt een beetje af van de eerdergenoemde frameworks, en is beter aan te passen aan je behoeftes en omstandigheden, zodat je gedwongen wordt objectiever te zijn in je beoordelingen en beslissingen. In plaats van drie factoren zoals bij ICE en PIE bestaat dit framework uit een reeks vragen waar je ja of nee op kunt antwoorden, evenals vragen over hoe makkelijk de test uit te voeren is. Het PXL framework stelt bijvoorbeeld de vraag: “Is deze test ontworpen om klanten gemotiveerder te krijgen?” Zo ja, dan scoort hij een 1, zo niet dan scoort hij een 0. Via de volgende link vind je meer informatie over dit framework en kun je de spreadsheet downloaden (Engelstalig).

Hopelijk heb je nu een beter idee met welke tests je het best kunt starten, én een handig manier om al je test-ideeën in categorieën in te delen. Ikzelf heb kortgeleden conversieonderzoek gedaan waarbij ik drie categorieën gebruikte: implementeren, onderzoeken en testen.

- Implementeren. Over dit idee hoef je niet na te denken, je kunt het meteen toepassen zonder eerst te hoeven testen. Het is overduidelijk dat het nu meteen nodig en nuttig is.

- Onderzoeken. Er is meer tijd nodig om het probleem beter te omschrijven of de oplossing specifieker te krijgen.

- Test. Dit is een goed idee en het wordt ondersteund door data. Klaar om te testen!

Als je al je ideeën op de bovenstaande manieren hebt ingedeeld en gerangschikt, weet je zeker dat je de juiste eruit pikt om mee aan de gang te gaan.

Spoedcursus statistiek voor A/B testing

Voordat je met een test van start gaat, is het belangrijk om je goed te verdiepen in de statistische gegevens die erbij horen. Ik weet dat de meeste mensen het al benauwd krijgen bij het zien van het woord statistiek, maar zie het maar als de zure appel waar je doorheen moet bijten om je conversieratio blijvend te kunnen verhogen.

Het is handig om telkens voor ogen te houden waar we statistiek voor gebruiken, en dat is eigenlijk heel simpel: bewijzen dat verschillende uitkomsten niet op toeval berusten, maar dat A écht beter/sneller/groter is dan B.

Alex Birkett, Growth Marketing Manager bij HubSpot:

Het gemiddelde

Je doel is om een gemiddelde te vinden dat representatief is voor het geheel, dus voor alle data die je verzameld hebt.

Je kunt bijvoorbeeld op zoek zijn naar de gemiddelde prijs van videogames. Het is onmogelijk om de prijs van alle videogames ter wereld te vinden, op te tellen en vervolgens te delen door de hoeveelheid games. In plaats daarvan doe je een steekproef die representatief is voor alle videogames ter wereld.

Dat komt meestal neer op de gemiddelde prijs van een paar honderd videogames. Als je steekproef representatief is, dus een goede doorsnee van alle soorten videogames bevat, dan is de gemiddeld prijs van die paar honderd videogames representatief voor de gemiddelde prijs van alle videogames ter wereld.

Steekproeven

Hoe meer items of elementen in je steekproef, hoe minder variantie, en hoe accurater het berekende gemiddelde.

Als je in plaats van een paar honderd een paar duizend videogames in je steekproef hebt, heb je minder variantie en een exacter gemiddelde, oftewel een gemiddelde wat dichter bij het werkelijke gemiddelde van alle videogames ter wereld komt.

Variant

De variant is de gemiddelde variëteit. Wat betekent dat? Hoe groter de variant, hoe verder je voorspelling of berekening van het werkelijke gemiddelde afzit.

Oftewel: hoe dicht zit jouw berekende gemiddelde bij de werkelijke prijs van elke individuele videogame?

Statistisch significant

Stel dat je gekozen A en B exact hetzelfde zijn, hoe vaak zul je dan tóch een verschil zien, puur gebaseerd op toeval?

Hoe lager het significantielevel, hoe groter de kans dat de “winnaar” van je A/B test helemaal geen echte winnaar is en dat het verschil puur door toeval komt (dit heet ook wel vals positief). Je wilt dus een verschil tussen A en B krijgen dat zó groot is dat je het niet meer aan toeval kunt toeschrijven.

Pas op: de meeste A/B test-tools en open source A/B testing software roepen een variant tot “winnaar” uit door hem als statistisch significant te benoemen, zonder te wachten tot een vooraf bepaalde hoeveelheid bezoekers (of datum) is bereikt. Daarom zie je vaak dat de test gedurende de looptijd heen en weer slingert tussen statistisch significant en statistisch insignificant.

Peep Laja, oprichter van het CXL-instituut zou willen dat meer mensen begrijpen wat de statistische significantie van een A/B test echt inhoudt, en waaróm het zo belangrijk is.

Regressie naar het gemiddelde

In de eerste week van je A/B test zul je vermoedelijk heftig fluctuerende resultaten zien.

Regressie naar het gemiddelde is een fenomeen waarbij een extreme uitslag bij de eerste meting voorspelt dat de uitslag van de volgend meting vermoedelijk stukken dichter bij het werkelijke gemiddelde zal liggen.

Als je een test stopzet zodra je statistische significantie bereikt hebt, loop je risico op een vals-positieve uitslag. De kans is groot dat dezelfde variant bij een tweede (en verder) meting regressie naar het midden vertoont, en dus niet meer statistisch significant is.

Onderscheidende kracht

Stel dat er inderdaad een verschil is tussen A en B, hoe vaak zie je daar dan het effect van?

Hoe kleiner de onderscheidende kracht, hoe groter de kans dat je in je test geen duidelijk winnaar zult zien, en vice versa. Het belangrijkste om te weten is dat 80% onderscheidende kracht de standaard setting is van de meeste A/B- en split test tools.

Tom Wesseling, oprichter van Online Dialogue, zou willen dat meer mensen het concept van onderscheidende kracht begrijpen.

Externe stoorzenders

Er zijn een aantal externe factoren die de betrouwbaarheid van je testuitslag negatief kunnen beïnvloeden. Denk hierbij bijvoorbeeld aan:

- Black Friday Cyber Monday (BFCM)

- Een positief (of negatief) verhaal in de media over je merk

- De lancering van een grote advertentiecampagne

- Een specifieke dag van de week

- Het juiste (of verkeerde) seizoen

Eén van de meest voorkomende voorbeelden van hoe A/B testing beïnvloed kan worden door externe factoren is seizoensgebonden pieken in verkoop. Stel dat je je test in december wilt doen. Doordat er in deze maand zoveel gekocht wordt krijgt je webshop vermoedelijk een stuk meer bezoekers, en vermoedelijk blijkt dat de winnende variant uit december het in januari helemaal niet meer zo goed doet.

De reden?

Een externe stoorzender: de feestdagen.

De gegevens waarmee je de winnende variant bepaalde waren een uitzondering. Als alles in januari weer tot rust is gekomen kan het zomaar gebeuren dat de winnende variant eigenlijk de verliezer blijkt.

Je kunt externe stoorzenders helaas niet vermijden, maar je kunt hun effect wel beperken door je test een hele week lang te laten duren (dus 7 hele dagen in plaats van alleen maandag tot en met vrijdag), door meerdere soorten bezoekers tegelijk te testen (test bijvoorbeeld niet alleen op betaalde bezoekers om het resultaat vervolgens te gebruiken voor alle soorten bezoekers), en door je bewust te zijn van de mogelijke stoorzenders bij A/B testing.

Een A/B test opzetten

In dit gedeelte geef ik je een korte tutorial in het opzetten van een A/B test. Voordat je kunt beginnen met testen moet je eerst een degelijke hypothese hebben.

In tegenstelling tot een idee is een hypothese meetbaar, heeft als doel een specifiek (conversie)probleem op te lossen, en is gericht op het verkrijgen van nieuwe inzichten in plaats van alleen maar op “winnen”.

Bij een A/B-test test je een hypothese, niet een idee.

Als ik een hypothese wil opstellen gebruik ik de volgende formule, die ik gevonden heb in Craig Sullivan’s Hypothesis Kit (Engelstalig):

- Omdat ik gemerkt hebt dat [data en/of feedback van eerder onderzoek]

- Verwacht ik dat [de verandering/verbetering die je wilt gaan testen] zorgt voort [impact die je verwacht] en

- Die impact meet ik door middel van [de data meetlat die je gaat gebruiken]

Makkelijk, toch? Je hoeft alleen maar de lege plekken in te vullen en je testidee is veranderd in een hypothese.

Een A/B test tool kiezen

Nu je je hypothese geformuleerd hebt, is het tijd om een goede A/B test tool of split test service te kiezen. De meest gangbare zijn Google Optimize, Optimizely en VWO , alle drie degelijke en veilige opties.

- Google Optimize. Gratis (behalve een paar geavanceerde functies die je nu nog niet nodig hebt). Zeer geschikt voor het uitvoeren van Google Analytics A/B tests.

- Optimizely. Kleinere tests zijn makkelijk op te zetten en te runnen, ook als je geen technische skills hebt. De Stats Engine helpt je bij het analyseren van je testresultaten. Optimizely is de duurste tool van de drie.

- VWO. VWO heeft SmartStats om het analyseren makkelijker te maken. Daarnaast heeft het een supergoede, makkelijk te begrijpen editor voor beginners. Elk soort VWO-abonnement heeft heatmaps, enquêtes die je aan je webshop kunt toevoegen, analysetools en nog veel meer.

De Shopify App Store heeft ook een aantal tools voor A/B tests die je kunnen helpen.

Als je eenmaal de tool of software hebt gekozen die bij je past, vul je het aanmeldingsformulier in en volg je de instructies. Bij elke tool ziet dit proces er weer anders uit. Maar over het algemeen word je gevraagd om een snippet op je webshop te installeren en doelen in te stellen.

A/B-test resultaten analyseren

Ik zei eerder in dit artikel dat een hypothese de focus verplaatst van “winnen” naar nieuwe inzichten verkrijgen. Krista Seiden, Analytics Advocate en productmanager bij Google legt uit wat daarmee bedoeld wordt.

"Met de juiste hypothese is ook de verliezende variant een winnaar."

Een andere factor om op te letten is segmentatie. Bij het opmaken van de eindstand komt één van de varianten misschien als algemene verliezer uit de bus, maar er is grote kans dat hij het bij in ieder geval één klantensegment wél heel goed deed. Denk voor segmenten aan bijvoorbeeld:

- Nieuwe bezoekers

- Terugkerende bezoekers

- iOS bezoekers

- Android bezoekers

- Chrome bezoekers

- Safari bezoekers

- Desktop bezoekers

- Tablet bezoekers

- Organisch zoekresultaat bezoekers

- Betaalde bezoekers

- Sociale media bezoekers

- Klanten die al ingelogd zijn

Etcétera.

In je test-tool worden alle resultaten op één hoop gegooid, alle Smarties in één emmer. Jouw taak is om alle Smarties op kleur te sorteren en kijken wat voor resultaten je dan ziet. Grote kans dat je verliezende variant bij sommige segmenten juist de winnaar is, informatie waar je nu en in de toekomst je voordeel mee kunt doen.

Analyse gaat over zoveel meer dan welke variant gewonnen of verloren heeft. Kijk naar de afzonderlijke segmenten van je data, want daar zitten verborgen inzichten die heel waardevol kunnen zijn.

A/B test-tools zullen dit niet voor je doen, dus het is een belangrijke vaardigheid om zelf te ontwikkelen.

Zo bewaar je de resultaten van je A/B tests

Stel dat je morgen je eerste test doet. Weet je dan over twee jaar nog precies wat de uitslag was en waarom? Vermoedelijk niet.

Daarom is het belangrijk om de resultaten van je A/B tests goed (en goed georganiseerd) te bewaren. Zonder een goed onderhouden test-archief gaan alle inzichten die je vergaard hebt verloren. Bovendien is de kans groot dat als je je testresultaten niet bewaart, je dezelfde tests twee keer doet.

De “enige juiste manier” van testresultaten bewaren bestaat niet, maar tools zoals Projects, Effective Experiments of een simpele Excel spreadsheet kunnen je een eind op weg helpen. In principe kun je je archief inrichten zoals je zelf wilt, als het maar de volgende elementen bevat:

- Je hypothese

- Screenshots van de controleversie en de variant

- Welke gewonnen/verloren heeft

- Inzichten die de analyse je gebracht heeft

In de loop der jaren zul je jezelf dankbaar zijn voor het bijhouden van dit archief. Het is namelijk niet alleen handig voor jou, maar ook voor nieuw personeel en stakeholders.

Zo pakken professionals hun A/B testing aan

Nu je weet hoe standaard A/B tests eruitzien, is het een goed moment om eens te gaan kijken hoe de professionals van bedrijven als Google en Hubspot het precies aanpakken.

Krista Seiden, Google

Ik heb een stap-voor-stap-proces voor A/B testing voor apps en websites. De eerste stap is analyse, de basis voor elk goed testprogramma. Mijn doel tijdens de analyse is om alle gegevens die ik heb verzameld te bestuderen door middel van mijn eigen analyses, enquêtes en alle andere manieren om erachter te komen wat klanten doen en willen. Zo kom je erachter waar de mogelijkheden voor optimalisatie liggen.

Als je een aantal goede ideeën uit je analyse hebt gehaald, ga je bedenken wat de oorzaak zou kunnen zijn van de problemen die je hebt gevonden, én hoe je ze op zou kunnen lossen of verbeteren. Zet deze oplossingen om in hypotheses.

De volgende stap is het opzetten en uitvoeren van je test. Zorg dat je ze voldoende tijd geeft (ik ga zelf altijd voor twee weken om te compenseren voor eventuele afwijkende weken/dagen). Genoeg data verzameld? Analyseer je resultaten en bepaal welke variant de winnaar is.

Dit is ook het punt waarop je de verliezende varianten analyseert. Wat kun je van ze leren?

Als laatste, meestal pas als je alle kinderziektes uit je optimalisatieprogramma gehaald hebt, kun je je focussen op personalisatie. Hier heb je geen ingewikkelde tools voor nodig, puur goed inzicht in de data die je over je gebruikers hebt.

Marketing personalisatie kan heel eenvoudig zijn: zorgen dat de juiste content bij de juiste locatie (land, regio) terechtkomt, maar ook heel complex: targeting gebaseerd op het gedrag van individuele bezoekers. Begin hier heel voorzichtig mee, en zorg dat je eerst de basics van het optimaliseren helemaal onder de knie hebt.

Alex Birkett, HubSpot

Dit zijn de proces-stappen waar ik me aan probeer te houden:

- Verzamel de data en zorg dat je analysetools goed werken.

- Analyseer de data en vergaar inzichten.

- Zet die inzichten om in hypotheses.

- Zet de hypotheses op een rijtje, met de eenvoudigste hypotheses met de grootste impact bovenaan. Zorg dat je optimaal gebruikt maakt van je hulpbronnen (vooral van de technische tools).

- Voer de test uit (waarbij de focus ligt op het zo degelijk mogelijk aanpakken van het statistische gedeelte).

- Analyseer de resultaten, en implementeer de winnende variant in je webshop.

- Evalueer het testen zelf en neem dat mee voor de volgende test.

Kort samengevat: onderzoek doen, testen, analyseren, herhalen.

Soms wijk ik er een beetje van af of pas het aan, afhankelijk van de context (Test je een producteigenschap die grote invloed heeft op het succes van je bedrijf? De call to action van een blogpost? Hoeveel risico brengt de variant met zich mee? Wat is de balans tussen potentieel succesvolle innovatie versus het potentieel risico van diezelfde innovatie?), maar over het algemeen is het bovenstaande proces van toepassing op bijna alle bedrijven, ongeacht omvang en type.

Het proces is agile, maar zorgt ook voor voldoende gegevens, zowel kwalitatief (feedback van klanten) als kwantitatief (eigen analyse), zodat je test-ideeën beter worden en makkelijker te rangschikken zijn, allemaal om meer bezoekers op je webshop te krijgen.

Ton Wesseling, Online Dialogue

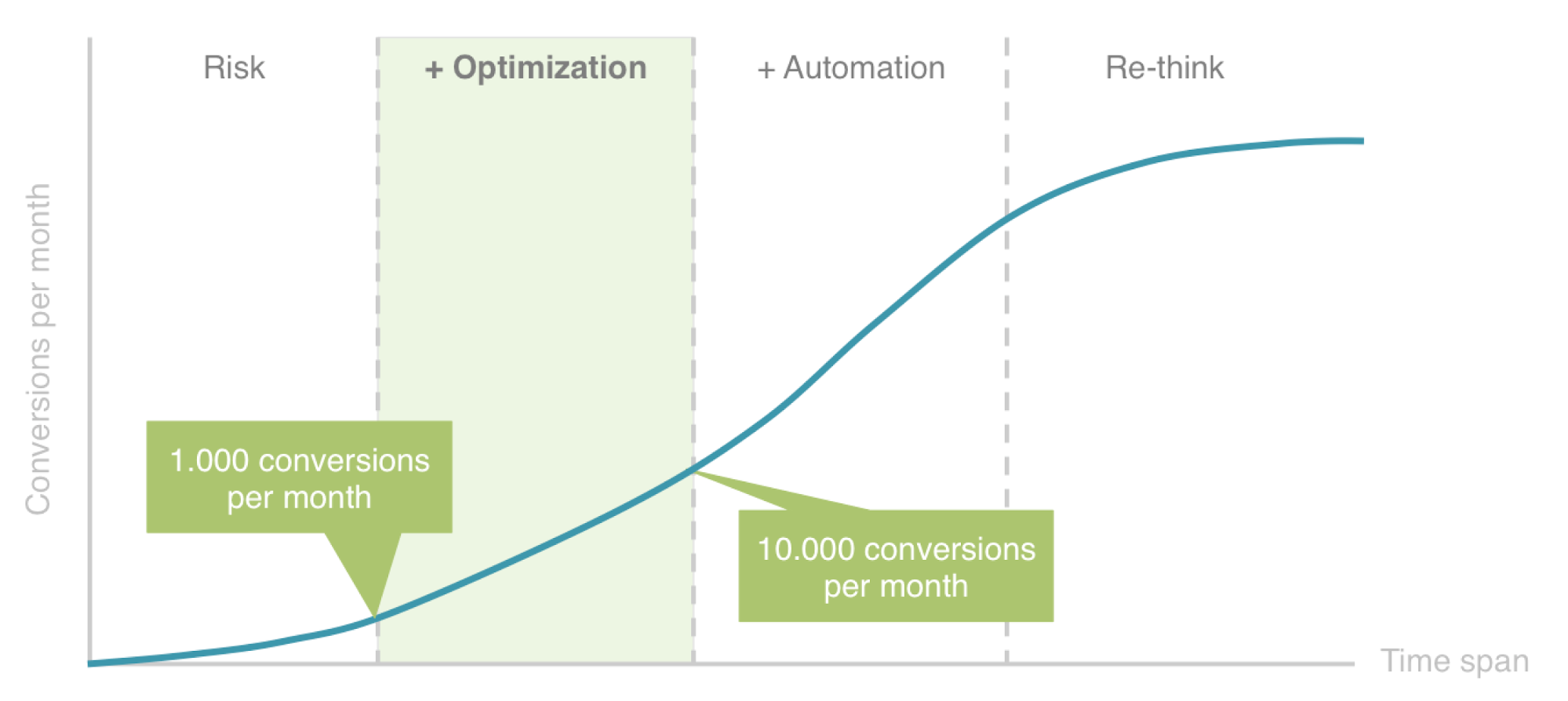

De eerste vraag die we onszelf altijd stellen als we de customer journey willen optimaliseren is: Waar past dit product of deze service in het ROAR-model dat we bij Online Dialogue gecreëerd hebben? Zit het nog in de risicofase, waar we wel veel onderzoek kunnen doen, maar onze conclusie nog niet met een A/B test kunnen testen (onder de 1000 conversies per maand), of zitten we al in de optimalisatiefase? Of zelfs nog een fase verder?

- Risicofase: hier doe je al je research, wat je vervolgens vertaalt naar bijvoorbeeld een aanpassing aan je bedrijfsmodel, een volledig nieuw ontwerp of een hele andere value proposition

- Optimalisatiefase: grotere experimenten om je value proposition en bedrijfsmodel te optimaliseren.

- Optimalisatiefase: kleine experimenten om hypotheses rondom klantengedrag te testen, wat bijdraagt aan je algemene kennis voor grotere aanpassingen in je ontwerp.

- Automatiseren: Als blijkt dat niet alle tools van de test (volledig) ingezet hoeven te worden om een duidelijke winnaar te bepalen, kun je de overgebleven “testkracht” gebruiken om andere, kleinere zaken te testen, die niet per se over de lange termijn gaan. Dit proces kun je automatiseren door middel van bandits of algoritmes.

- Re-think: In deze fase voeg je geen nieuw research meer toe, tenzij als het startpunt voor een nieuwe test.

Dus alleen tijdens de optimalisatie- en automatiseringsfases van het ROAR-model is een A/B test voor een app of webpagina de focus.

Voor het uitvoeren van de tests zelf gebruiken we het FACT&ACT model:

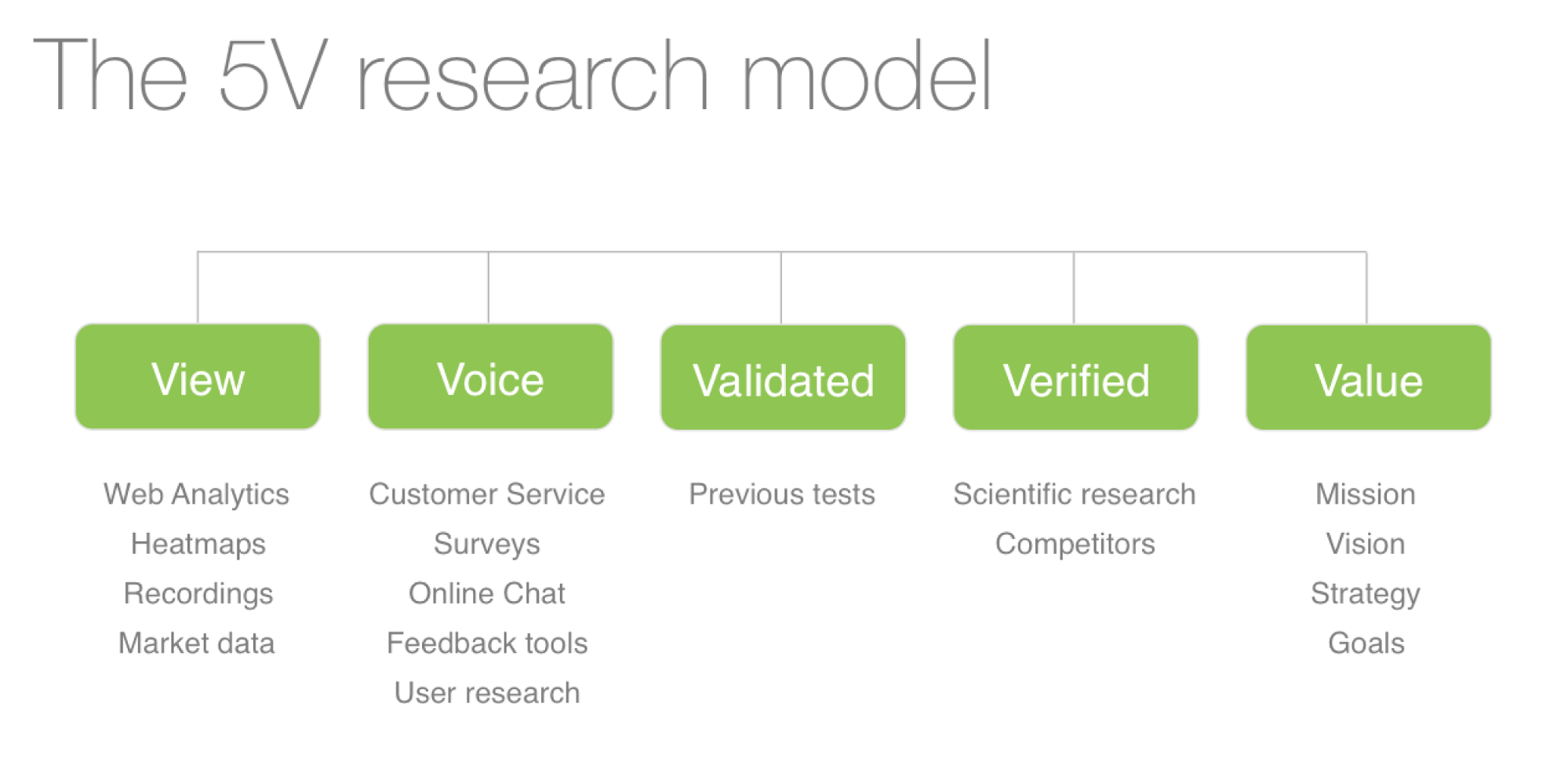

De research die we doen is gebaseerd op ons 5V model:

We brengen al deze inzichten samen om uiteindelijk tot een hypothese te komen die gebaseerd is op research. Die hypothese leidt tot sub-hypotheses die we rangschikken gebaseerd op de gegevens die we verzameld hebben via A/B tests op desktops of mobiele telefoons. Hoe groter de kans dat een hypothese waar blijkt te zijn, hoe hoger hij op de ranglijst komt.

Als we eenmaal weten of onze hypothese waar (of niet) is, kunnen we die kennis gaan combineren met eerdere gegevens, en grotere veranderingen doorvoeren in de customer journey. Maar er komt altijd een punt waarop je alle winnende varianten toegepast hebt en je het plafond hebt bereikt voor een specifieke doelgroep (bijvoorbeeld een land). Dan verleg je de focus naar de volgende, grotere stap: het bereiken van een wereldwijde optimale customer journey.

En de belangrijkste leerpunten deel je natuurlijk met het hele bedrijf, waardoor mensen op allerlei andere afdelingen hun eigen producten of processen ook kunnen optimaliseren, of nieuwe innovaties kunnen doen, allemaal gebaseerd op jouw bewezen hypotheses.

Is je marketing gericht op een internationaal publiek? Leer hier hoe je dat proces eenvoudiger kunt maken met pseudo-lokalisatie (Engelstalig).

Julia Starostenko, Shopify

Het doel van een experiment is om te bevestigen dat het veranderen van een bestaande webpagina een positieve impact heeft op je bedrijf.

Voordat je begint met experimenteren is het belangrijk om je af te vragen of het wel echt nodig is om een experiment te doen. Voorbeeld: je hebt een knop op je website waar bijna niemand op klikt, het is bijna niet mogelijk om de knop nog slechter te laten werken. Het is daarom niet nodig om eerst te moeten bewijzen, door middel van een experiment, dat een verandering aan die knop voordelig uit zal vallen.

Hetzelfde geldt voor situaties waarin de verandering die je in gedachten hebt maar klein is. In dat geval is het vermoedelijk niet de moeite waard om tijd te besteden aan het opzetten, uitvoeren en afbouwen van een experiment. In dit geval voer je de verandering simpelweg overal door, en houdt vervolgens goed in de gaten wat voor effect hij heeft.

Als je hebt vastgesteld dat een experiment wel de moeite waar is, is de volgende stap het identificeren van de bedrijfs-graadmeter die je wilt verbeteren (bijvoorbeeld de conversieratio van de knop verbeteren). Daarna zorg je dat je de juiste systemen hebt om alle data te verzamelen.

Als je dat hebt gedaan verdeel je je bezoekers (willekeurig) tussen twee groepen; één groep krijgt de bestaande versie van de knop te zien, de andere de nieuwe versie. De conversieratio van elke groep wordt gemonitord, en als je statistische significantie hebt bereikt bepaal je de winnaar van het experiment.

Peep Laja, CXL Instituut

A/B tests zijn een onderdeel van het grotere geheel van conversie optimalisatie. Ik zie A/B tests als 80% onderzoek en slechts 20% testen. Conversie-research kan je helpen om te beslissen met welke test je gaat beginnen.

Mijn proces (vereenvoudigd) ziet er meestal als volgt uit:

- Doe conversie-research met een framework zoals ResearchXL, en stel zo vast welke problemen je webshop heeft.

- Kies een probleem met hoge prioriteit (een serieus probleem waar de meeste gebruikers mee te maken krijgen) en doe een brainstorm om zoveel mogelijk oplossingen te vinden. Laat de inzichten uit je conversie research de richting van je ideeën bepalen. Bedenk voor welk type apparaat je de test wilt doen (je moet A/B tests voor mobiele telefoons versus desktops apart uitvoeren).

- Hoeveel mogelijke varianten zou je kunnen testen (gebaseerd op je hoeveelheid bezoekers/transacties)? Neem de (twee) beste oplossingen en vergelijk ze met de controlevariant in een A/B test.

- Schrijf/ontwerp de variant(en): schrijf de kopij, pas het ontwerp aan, etc. Afhankelijk van hoe ingrijpend de veranderingen zijn kan het een goed idee zijn om een ontwerper in te schakelen voor het uitvoeren van je nieuwe designs.

- Laat je front-end developers de veranderingen in je test-tool invoeren. Schakel belangrijke integraties (Google Analytics) in en bepaal de doelen van je test.

- Doe een kwaliteitsproef met je test. De belangrijkste reden dat A/B tests mislukken is dat de test zelf kapot of foutief is. Zorg dat de test werkt voor elke browser op elk apparaat.

- Begin de test!

- Doe een post-test analyse zodra de test is afgerond.

- Afhankelijk van het resultaat stap je over op de winnende variant, houd je het bij de oude versie, of maak je alles klaar om een nieuwe variant te testen.

Optimaliseer de A/B tests van je bedrijf

Met de bovenstaande tips en adviezen heb je alles in huis om optimale A/B tests uit te voeren. Doe je research, koop de beste A/B test software, en begin met testen. Voor je het weet bezorgen de inzichten die je verzamelt je meer omzet en snellere groei.

Als je nog meer wilt leren over optimalisatie is het een goed idee om een gratis cursus zoals Udacity A/B testing van Google te volgen. Hier leer je meer over A/B tests voor web- en mobiele apps, en voeg je nog meer tools toe aan je optimalisatie skillset.

Dit artikel is een vertaling van een origineel Shopify-artikel van Shanelle Mullin.

Meer lezen

- Tijd voor de belastingaangifte- 5 vragen en antwoorden over de zelfstandigenaftrek

- Nieuwe regels voor online verkopen- wat verandert er?

- Zo helpt business intelligence jouw webshop groeien (BI-tools uitgelicht)

- Prijsstrategie- zo bepaal je jouw prijzen voor de groothandel en retail

- Trek potentiële klanten over de streep met een webshop keurmerk

- Een liquiditeitsbegroting opstellen- tijdwinst, tips en een voorbeeld

- Zo kies je het juiste boekhoudprogramma voor jouw bedrijf (5 toppers vergeleken)

- Een SWOT-analyse maken doe je zo (stappenplan en SWOT voorbeeld)

- Financieel advies- 7 geldbesparende tips voor startende ondernemers

- Broodfonds- alternatief financieel vangnet bij arbeidsongeschiktheid zzp’ers